가짜 합성영상 판독하는 인공지능 기술

인공지능을 활용한 영상합성 기술이 나오면서 작년말 국내 여자연예인들의 합성영상이 인터넷에 퍼지면서 피해가 발생했었습니다.

물론 대부분의 사람들은 그 영상이 합성인 것을 눈치챘지만 피해를 입은 연예인들은 초상권이 침해된것은 물론이고 정신적 피해도 상당했을 것으로 보입니다.

지금은 어설퍼 보이는 영상합성기술이지만, AI 기술이 발전한다면 전문가들도 눈치채지 못할 정도로 정교한 영상이 만들어 질수도 있을 것 같은데요. 이 기술이 좋은곳에 사용된다면 문제가 없겠지만, 불순한 의도를 가진 사람이 사용한다면 큰 사회적 이슈가 될 것은 불보듯 뻔한 일입니다.

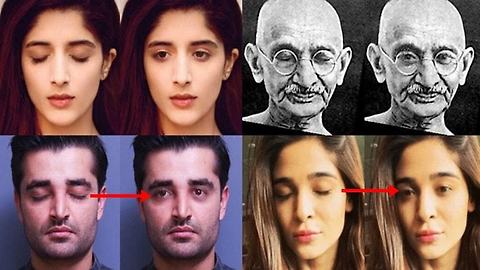

하지만 최근 합성영상 피해를 예방할 수 있는 인공지능기술이 발표됐습니다. 알바니(Albany) 대학에 재학중인 중국 학생들은 'In Ictu Oculi: Exposing AI Generated Fake Face Videos by Detecting Eye Blinking' 논문에서 AI로 합성한 영상은 호흡, 맥박, 눈 깜박임과 같은 무의식적인 생리활동까지 자연스럽게 합성할 수 없다는 사실을 밝혀냈습니다.

Exposing AI Generated Fake Face.pdf

Exposing AI Generated Fake Face.pdf

논문에 따르면 눈깜빡임 횟수는 평균적으로 휴식상태일 경우 17회, 대화 중인 경우 26회, 독서할 때 4.5회 라고 합니다. 하지만 Deepfake 기술을 이용해 합성된 영상은 눈깜빡임이 없기 때문에 쉽게 구분이 가능하다는 것이 논문의 주요내용입니다.

Deepfake 기술로 합성한 영상의 경우 데이터셋을 구글 이미지 검색을 통해서 수집하는데, 온라인게 공개된 사진들은 대부분 눈을 뜨고 있는 사진이기 때문에, 별도의 데이터셋을 확보하지 않는다면 눈깜빡이는 영상을 합성하기 어렵다는 한계가 존재합니다.

이전에 발표된 합성영상 탐지 논문들은 눈을 감았는지 떳는지를 감지하기 위해 EAR(eye aspect ratio) 또는 CNN (convolutional neural network-based) 분류자를 사용했는데, 이 경우 CNC기반 기술을 비디오의 개별 프레임 외에도 이전의 눈 상태를 고려하는 접근법인 RNN(재귀 신경 네트워크)과 결합했습니다.

연구팀은 LRCN (Long-term Recurrent Convolutional Network)을 사용해 눈 상태를보다 부드럽고 정확하게 예측할 수 있게 했는데, 이 방식은 정확도가 0.99로 CNN(0.98)이나 EAR(0.79) 방식보다 더 정교합니다.

물론 영상합성 기술 또한 계속해서 발전하고 있기 때문에 이 기술로 모든 합성영상을 판별할 순 없을 것 입니다. 하지만 마치 창과 방패의 싸움처럼 이런 AI 기술경쟁(?)이 음지에서의 AI기술활용은 방지하고, 사람들에게 도움을 줄 수 있는 분야에서 인공기술이 사용될 수 있는 방향으로 흘러 갔으면 하는 바램입니다.